Camada de ativação: Hyperbolic tangent

A função hyperbolic tangent, ou \( tanh \) é muito similiar a função de ativação softmax. Essa função é muito utilizada redes neurais recorrentes (Seção Redes neurais recorrentes (Recurrent neural networks)), especialmente nas arquiteturas GRU e LSTM. A função \( tanh \) tem a seguinte estrutura:

\[ \large{} y=tanh(z)= \frac{e ^z - e ^{-z}}{e ^z + e ^{-z}} \]

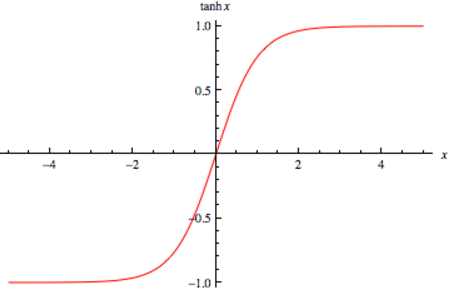

Assim como a softmax, a função \( tanh \) também gera valores entre -1 e 1, como percebemos na Figura 21, porém não gera a distribuição para \( K \) valores de classe.

Figura 21: Representação da função \( tanh \) usada para a camada de ativação